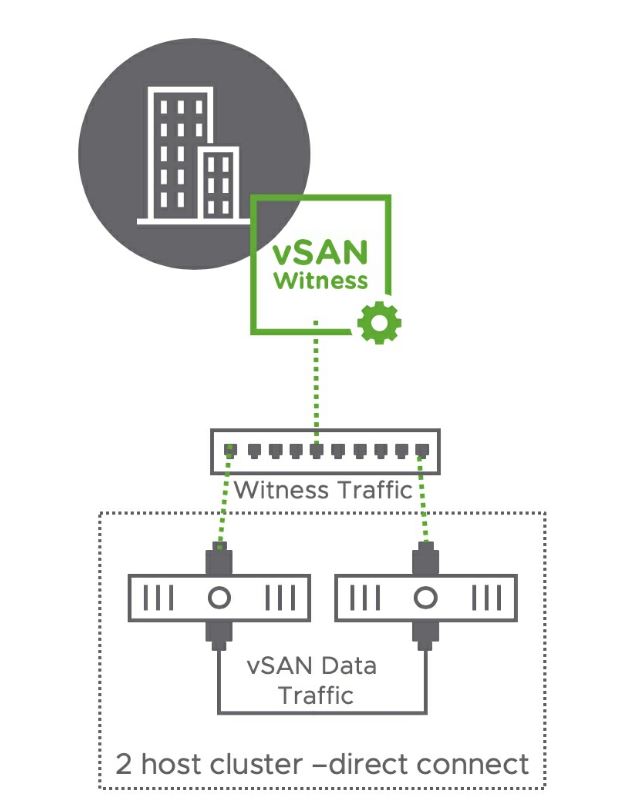

La configuration vSAN Cluster avec 2 nœuds a été introduite depuis la version vSAN 6.1 pour les clients qui cherchent à déployer leurs Workloads à travers le Remote Office/Branch Office.

Pour la mise en place, il suffit simplement de déployer 2 nœuds sur le même site et d’un witness (VM téléchargeable depuis le portail Vmware) déployé sur un deuxième site ou notamment hébergé sur un cloud public.

Il n’y a pratiquement aucune différence entre le déploiement du vSAN cluster avec 2 nœuds et vSAN Stretched cluster hormis que les 2 nœuds sont situés sur la même localisation géographique alors que pour le stretched cluster, les nœuds sont dispersées sur 2 sites différents. Par contre, elles ne fonctionnent pas de la même façon.

Il est a noté que cette configuration permet le vSAN DirectConnect (l’interconnexion réseau directe des 2 nœuds) et ainsi nous éviter de passer par un switch réseau.

Installation et configuration

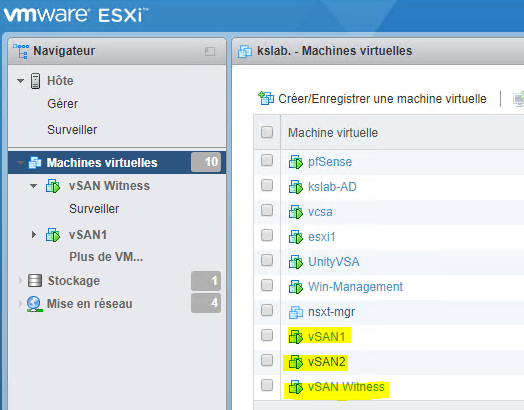

Pour ce lab, j’ai commencé par déployer:

- 2x nested ESXi avec la configuration suivante:

- 2 vCPU

- Mémoire: 10Gb

- Réseau: 3 Adaptateurs pour les trafics: Management, Witness, vSAN

- Disque: 3 HDD (ESXi, disque cache et disque de capacité)

- 1x vSAN Witness disponible en format OVA depuis ce lien

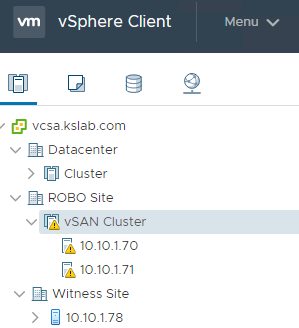

Une fois connecté au vCenter, nous procédons à l’ajout des 3 hôtes:

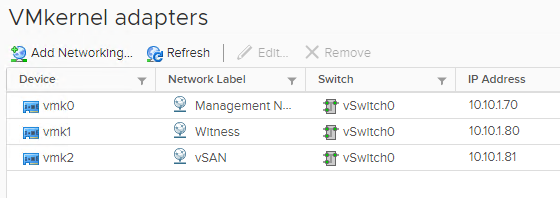

Avant d’activer vSAN, il est important de procéder à configurer correctement la partie réseaux. Ci-dessous une vue des adaptateurs VMkernel des nested ESXi:

- vmk0: Management

- vmk1: Witness

- vmk2: vSAN

Pour activer le trafic Witness sur vmk1, il faudrait se connecter en SSH sur chacune des ESXi (sauf le Witness) et exécuter la commande ci-dessous:

esxcli vsan network ip add -i vmk1 -T=witness

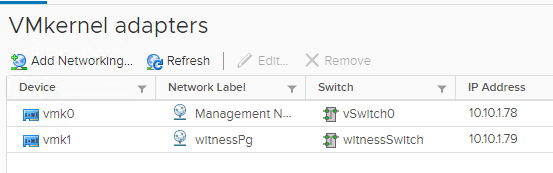

Et ci-dessous une vue des adaptateur VMkernel du Witness. Pour mon cas, j’ai laisser la configuration par défaut:

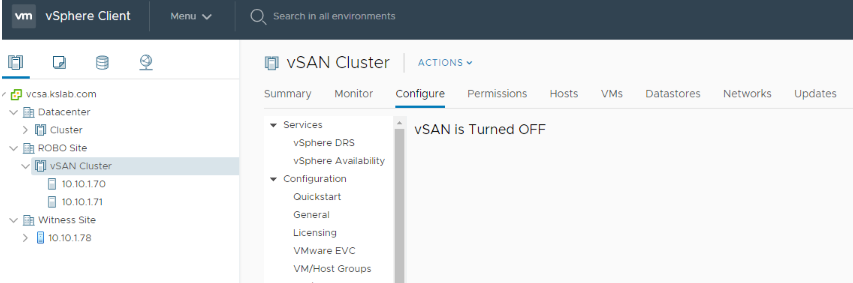

Une fois les adaptateur configurer, nous pouvons commencer par activer vSAN:

On choisi la configuration 2 hôtes:

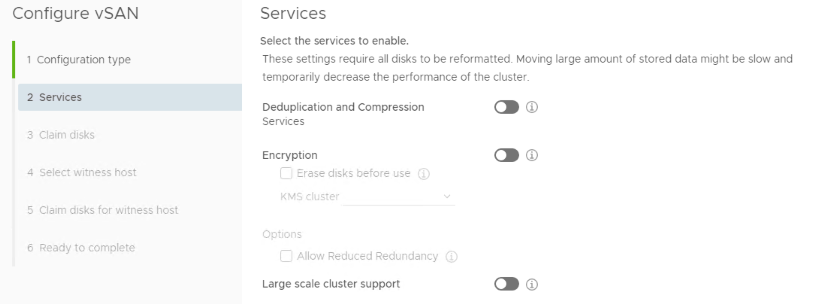

J’ai gardé les services tels que Deduplication/Compression et Encryption désactivés:

L’étape suivante consiste à assigner les disques cache et de capacité de mes 2 hôtes nested ESXi:

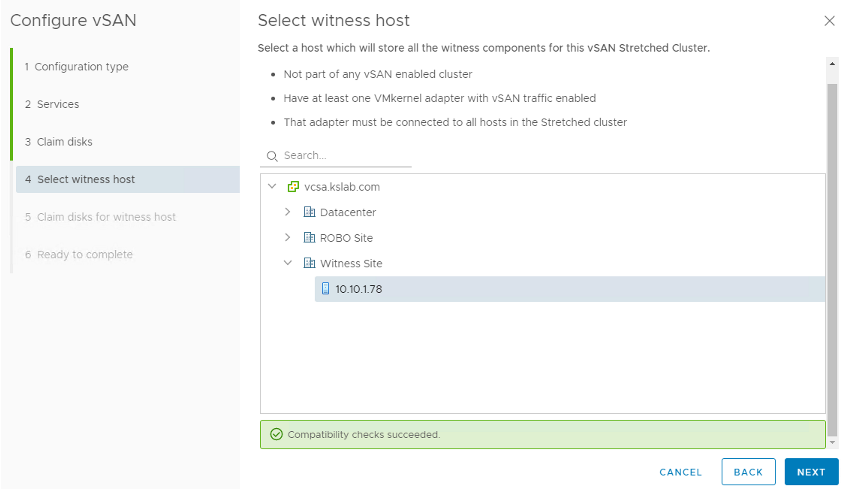

Le Wizard continue et nous mène à la phase de l’ajout du Witness au Cluster vSAN:

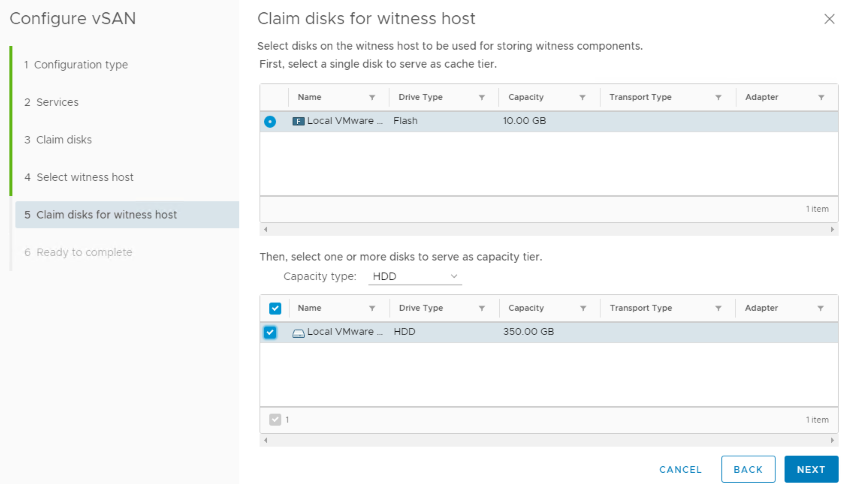

Tout comme les 2 nested ESXi, nous assignons les disques cache et de capacité du Witness:

Une fois la configuration terminée, un récapitulatif s’affiche afin de valider la configuration:

vSAN s’active au bout d’un petit moment. Afin de vérifier l’état du cluster nous procédons à la vérification du vSAN sur Health:

Les fault domains sont configurés automatiquement afin de déterminer l’hôte préféré et l’hôte secondaire du cluster:

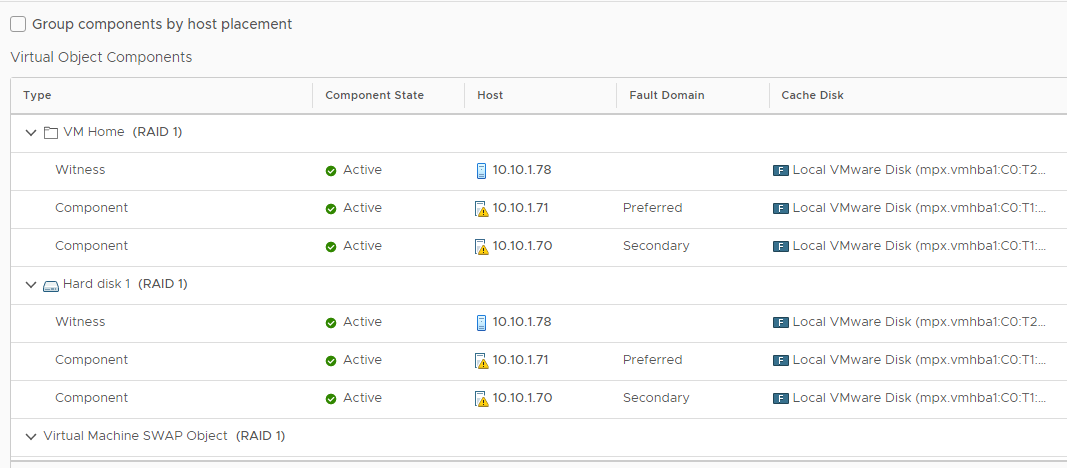

Une fois le cluster vSAN déployé et activé, nous avons procédé à la création d’une machine Ubuntu. Il est a noté que la protection des VMs sur un cluster vSAN avec 2 hôtes se fait seulement avec le RAID 1, avec le SPBM par défaut. Une fois créer, la répartitions des VMs se fait comme suit:

Sur la vidéo qui suit, vous allez voir comment vSAN fait face aux pannes de l’hôte préféré:

J’espère que ces informations vous seront utiles. Surtout n’hésitez pas à poster des commentaires en cas de besoins ou de partager vos idées pour améliorer l’article.

Merci Karim pour cet article,

J’ai deux questions si vous me permettez :

1. dans le cluster ROBO ce ne sont pas des nested ESXi ce sont des hosts physiques ?

2. Pourquoi séparer le trafic witness de management ?

Merci

J’aimeJ’aime

Merci pour le feedback.

1- Ce sont des nested ESXi et non des hôtes physique.

2- Il aurait pu êre aussi configuré avec le management. Le Witness trafic doit impérativement être séparé uniquement du vSAN trafic.

J’aimeJ’aime

Bonjour Karim

Cette configuration est donc indépendante du matériel utilisé ? est-ce que vous l’avez déjà utilisé avec du HPe simplivity (avec stretched cluster) ? comment se passe la demande de bande passante est-ce qu’il y a beaucoup de trafic réseau généré pour la communication des 2 noeuds ?

J’aimeJ’aime

Bonjour Herizo

Cette configuration est basé sur du vSAN Ready node. HPE Simplivity utilise une autre technologie basé sur Omnistack, donc incompatible vSAN. Le trafic réseau est considérable seulement pendant la première mise en place du mirroring des VM.

J’aimeJ’aime

Bonjour Herizo,

Merci ton article très bien réalisé.

Quelques questions que je me pose et dont je n’ai pas clairement trouvé réponse.

Niveau licencing :

J’ai 3 nodes mono processeurs avec une licence essential kit. Est ce que je peux l’utiliser pour faire du vsan? Combien de licence vsan standard il me faut si je fait un cluster 2 nodes et Witness sur le troisième esxi . Je suppose 2 ?

Question matériel :

Est ce que pour les disques de capacité tier, je peux sur ma machine physique créer un raid5 de 4to et le présenter comme un disque physique a vmware. Afin d’avoir une resiliences supplémentaires au raid1 soft de vsan créé avec mes 2 nodes

Merci bien

J’aimeJ’aime

Bravo Karim,

Cela me fait chaud au cœur de faire une recherche sur Net pour trouver un article m’aidant à configurer vSAN et de découvrir l’article de mon ancien étudiant. Bravo Karim et très bonne continuation

J’aimeAimé par 1 personne

Merci Mme Abir pour le commentaire. Je suis ravi et j’espère que vous trouverez l’article utile

J’aimeJ’aime